😵 (1/2) 20 шагов, если Google Ads скрывает поисковые запросы с 80% кликов.

Вопрос из чата №48 от 26.08.24:

Путь только один — идти на опережение и заведомо запретить Гуглу показывать вас по любому потенциальному мусору, который не отображается в скрытых поисковых запросах.

————

⚠️ Дисклеймер:

Это не поможет избежать факта скрытия 80% кликов по поисковым запросам, но точно поможет сократить долю нецелевого трафика в рамках этих скрытых запросов.

————

Для этого нужно отминусовать как можно больше нецелевой лексики, которую сам Гугл считает релевантной любым ключам и урлам из вашей отрасли.

Собрать мусор можно из планировщика Google Ads по:

🥷 Вашему домену.

🥷 Урлам вашего сайта.

🥷 Доменам конкурентов.

🥷 Каждому урлу каждого из домена конкурентов.

🥷 Добавленным ключам в ваш аккаунт.

🥷 Целевым поисковым запросам из статистики, которые ещё не добавлены в ключи аккаунта.

🥷 Остальной отраслевой, околоотраслевой, межотраслевой, конкурентной и прочей нецелевой семантике, которой нет ни в ключах, ни в статистике запросов, но которую придётся собрать самостоятельно из различных источников, включив мозжечок спинного надмозга.

Задача — собрать семантику по каждому из этих 7 пунктов, и из этой семантики собрать не только минус-слова, а ещё и слишком широкие минус-фразы для их исключения в [точном соответствии].

————

Пошаговый алгоритм:

1️⃣ Спарсить в Screaming Frog SEO Spider все урлы вашего домена. Если на сайте тысячи страниц, парсите по регулярным выражениям:

🥷 Либо по включениям нужных урлов — так время на парсинг будет во много раз меньше:

1️⃣ Сначала — категорийных разделов — по этим урлам вы будете выгружать семантику из планировщика Google Ads, и абсолютное большинство семантики Гугл вам отдаст по категорийным урлам.

2️⃣ Затем — подкатегорийных разделов — по этим урлам вы спарсите остатки несобранной семантики после этапа прохождения по категорийным урлам. Но парсить подкатегорийные урлы и загружать их в планировщик ключей Гугла будет смысла мало, т.к. вложенную глубину и синонимичную ширину ключей вы уже соберёте при выгрузке семантики с более широких категорийных разделов.

3️⃣ И в последнюю очередь — специфические узконаправленные страницы (карточки, страницы товаров и т.д.) — выгружать по ним семантику из планировщика Google Ads целесообразно только если это что-то с высоко- или среднечастотным спросом, иначе Гугл отдаст в прогнозе ноль новых ключей.

🥷 Либо по исключениям ненужных урлов — наиболее предпочтительный способ сбора

Парсинг урлов по включениям опасен тем, что в незнакомой структуре сайта вашего заказчика и любых его конкурентов вы можете не знать, какие урлы находятся в каких разделах, более того, страницы могли ранее добавляться на сайт неопытными специалистами, и могло быть не создано вообще никакой структуры.

Парсинг по исключениям безопаснее тем, что вы будете в 5-10 последовательных итераций перезапускать парсинг и при каждом перезапуске вносить в исключения ещё по 1-2 ненужных разделов или каких-либо паттернов символов в урле. Примерно после 7-10 итераций перезапусков в результатах парсинга практически одни только нужные категорийные урлы.

2️⃣ Каждый URL вставить в планировщик Google Ads и выгрузить прогноз ключей:

🥷 По домену.

🥷 По точным URL.

3️⃣ Ключи из аккаунта повставлять по 10 штук в планировщик Google Ads и собрать прогноз фраз. Создать отдельную папку на компе и сложить туда все выгрузки.

4️⃣ Пункт 3 повторить с целевыми поисковыми запросами из статистики. Файлы выгрузки сложить в ту же папку.

⬇️ Остальные 16 шагов в следующем посте.

via @ppc_bigbrain

Вопрос из чата №48 от 26.08.24:

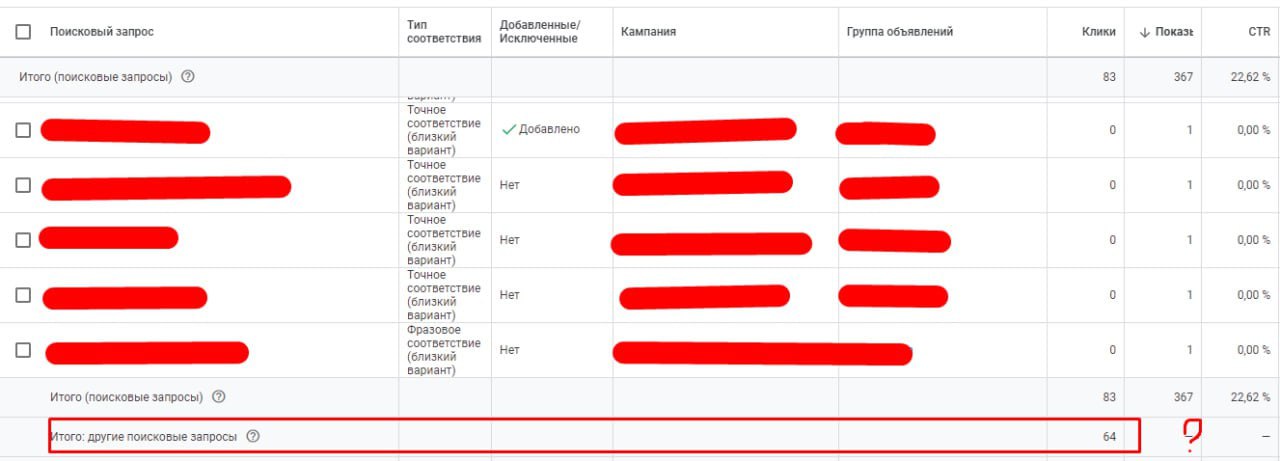

Лично у меня классическая бяда [на скриншоте 77% кликов — по скрытым поисковым запросам]. И не лечится. Задолбал Гугл своей этой байдой. Как быть, вечный вопрос.

Путь только один — идти на опережение и заведомо запретить Гуглу показывать вас по любому потенциальному мусору, который не отображается в скрытых поисковых запросах.

————

⚠️ Дисклеймер:

Это не поможет избежать факта скрытия 80% кликов по поисковым запросам, но точно поможет сократить долю нецелевого трафика в рамках этих скрытых запросов.

————

Для этого нужно отминусовать как можно больше нецелевой лексики, которую сам Гугл считает релевантной любым ключам и урлам из вашей отрасли.

Собрать мусор можно из планировщика Google Ads по:

🥷 Вашему домену.

🥷 Урлам вашего сайта.

🥷 Доменам конкурентов.

🥷 Каждому урлу каждого из домена конкурентов.

🥷 Добавленным ключам в ваш аккаунт.

🥷 Целевым поисковым запросам из статистики, которые ещё не добавлены в ключи аккаунта.

🥷 Остальной отраслевой, околоотраслевой, межотраслевой, конкурентной и прочей нецелевой семантике, которой нет ни в ключах, ни в статистике запросов, но которую придётся собрать самостоятельно из различных источников, включив мозжечок спинного надмозга.

Задача — собрать семантику по каждому из этих 7 пунктов, и из этой семантики собрать не только минус-слова, а ещё и слишком широкие минус-фразы для их исключения в [точном соответствии].

————

Пошаговый алгоритм:

1️⃣ Спарсить в Screaming Frog SEO Spider все урлы вашего домена. Если на сайте тысячи страниц, парсите по регулярным выражениям:

🥷 Либо по включениям нужных урлов — так время на парсинг будет во много раз меньше:

1️⃣ Сначала — категорийных разделов — по этим урлам вы будете выгружать семантику из планировщика Google Ads, и абсолютное большинство семантики Гугл вам отдаст по категорийным урлам.

2️⃣ Затем — подкатегорийных разделов — по этим урлам вы спарсите остатки несобранной семантики после этапа прохождения по категорийным урлам. Но парсить подкатегорийные урлы и загружать их в планировщик ключей Гугла будет смысла мало, т.к. вложенную глубину и синонимичную ширину ключей вы уже соберёте при выгрузке семантики с более широких категорийных разделов.

3️⃣ И в последнюю очередь — специфические узконаправленные страницы (карточки, страницы товаров и т.д.) — выгружать по ним семантику из планировщика Google Ads целесообразно только если это что-то с высоко- или среднечастотным спросом, иначе Гугл отдаст в прогнозе ноль новых ключей.

🥷 Либо по исключениям ненужных урлов — наиболее предпочтительный способ сбора

Парсинг урлов по включениям опасен тем, что в незнакомой структуре сайта вашего заказчика и любых его конкурентов вы можете не знать, какие урлы находятся в каких разделах, более того, страницы могли ранее добавляться на сайт неопытными специалистами, и могло быть не создано вообще никакой структуры.

Парсинг по исключениям безопаснее тем, что вы будете в 5-10 последовательных итераций перезапускать парсинг и при каждом перезапуске вносить в исключения ещё по 1-2 ненужных разделов или каких-либо паттернов символов в урле. Примерно после 7-10 итераций перезапусков в результатах парсинга практически одни только нужные категорийные урлы.

2️⃣ Каждый URL вставить в планировщик Google Ads и выгрузить прогноз ключей:

🥷 По домену.

🥷 По точным URL.

3️⃣ Ключи из аккаунта повставлять по 10 штук в планировщик Google Ads и собрать прогноз фраз. Создать отдельную папку на компе и сложить туда все выгрузки.

4️⃣ Пункт 3 повторить с целевыми поисковыми запросами из статистики. Файлы выгрузки сложить в ту же папку.

⬇️ Остальные 16 шагов в следующем посте.

via @ppc_bigbrain